什么是深度伪造?

© PANETTA AND BURGUND

利维坦按:

目前,人工智能程序GPT-3版本(人工智能研究实验室OpenAI开发)已经完全可以胜任一般性质文章的写作了:只要给它一个拟定的主题和基调,它就会“写出”一篇没有语法错误、逻辑清晰、条理缜密的文章来……别说一般的新闻通稿了,就连长篇幅的深度文章都已经做到了。更可怕的是,GPT-3可以进行各种文体风格的写作:煽动性的网文、亲纳粹性质的宣言,甚至可以有模有样地来回答你的提问。

同样,和互联网上的“伪书”一样,图片、视频乃至声音都已经实现了“深度伪造”。以假乱真的例子不胜枚举,除去那些恶搞为目的的视频,有大量的“深伪”其实是制造了更多的混乱,其导致的一个最直接的恶果就是:人们在本就难以分辨是非的互联网平台上更加难以辨别真伪。毕竟,有多少普通人会学习一门技术,来确定眼前的这段视频是否是真实的呢……

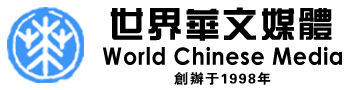

你见过贝拉克·奥巴马骂唐纳德·川普是“彻头彻尾的白痴”吗,见过马克·扎克伯格吹嘘自己“窃取了数十亿人的数据,并玩弄于股掌”吗,见过琼恩·雪诺为《权力的游戏》的凄惨结局而由衷道歉吗?你若回答“是”,便是看到了深度伪造(DeepFake)。

深度伪造奥巴马的视频。© youtube

深度伪造是21世纪人们对Photoshop的开发,使用“深度学习”这种人工智能形式来捏造虚假图像,因此得名“深度伪造”。要想让人们觉得一个新词是由某个政客所说,想要在自己喜爱的电影里当影星,或者像专业舞者那样翩翩起舞,那么,是时候进行深度伪造了。

深度伪造作用何在?

很多时候其为欲望所需。2019年9月,人工智能公司Deeptrace在网上检索出1.5万个深度伪造视频,且数量9个月内翻了近一倍,出乎意料的是,其中96%是小片片,其中99%将女明星换脸到小片片演员身上。(deeptracelabs.com/mapping-the-deepfake-landscape/)

© Wired UK

新技术的存在,让许多小白都可以用少量照片来进行深度伪造,这类假视频很可能会蔓延,不仅仅再局限于明星圈,助长复仇情色(revenge porn,指在未经当事人同意的情况下擅自发布露骨图片或视频到网上,编者注)。正如波士顿大学(Boston University)法学教授丹妮尔·西特龙(Danielle Citron)所言:“深度伪造技术正用作针对女性的武器。“除了小片片,还有大量的恶搞、讽刺和恶作剧因素参差其中。

仅仅能伪造视频吗?

答案是否定的。

深度伪造技术可以从零开始,捏造出令人信服、但完全虚构的照片。彭博社记者“梅西·金斯利(Maisy Kinsley)”在领英网(Linkedin)和推特上都有个人资料,而此人在现实中并不存在,这很可能就是深度伪造。另一个领英网虚拟人“凯蒂·琼斯(Katie Jones)”自称在美国战略与国际研究中心工作,但人们认为,这是为外国间谍活动而进行的深度伪造。

英国前首相特蕾莎·梅的真实镜头(左)与使用深度伪造技术合成的影像(右)。© Gizmodo Australia

音频也可以进行深度伪造,用于制作公众人物的“声音皮肤(voice skin)”或“声音克隆(voice clone)”。德国一家能源公司在英国设有子公司,2019年3月,该子公司首席执行官在接到一通电话后,向匈牙利的一个银行账户支付了近20万英镑。骗子模仿德国首席执行官的声音对其进行诈骗,该公司的保险公司认为这个声音是深度伪造的,但尚无证据。据报道,类似的诈骗案例实际上是窃取了WhatsApp的录音语音信息,并对其进行深度伪造。(www.wsj.com/articles/fraudsters-use-ai-to-mimic-ceos-voice-in-unusual-cybercrime-case-11567157402)

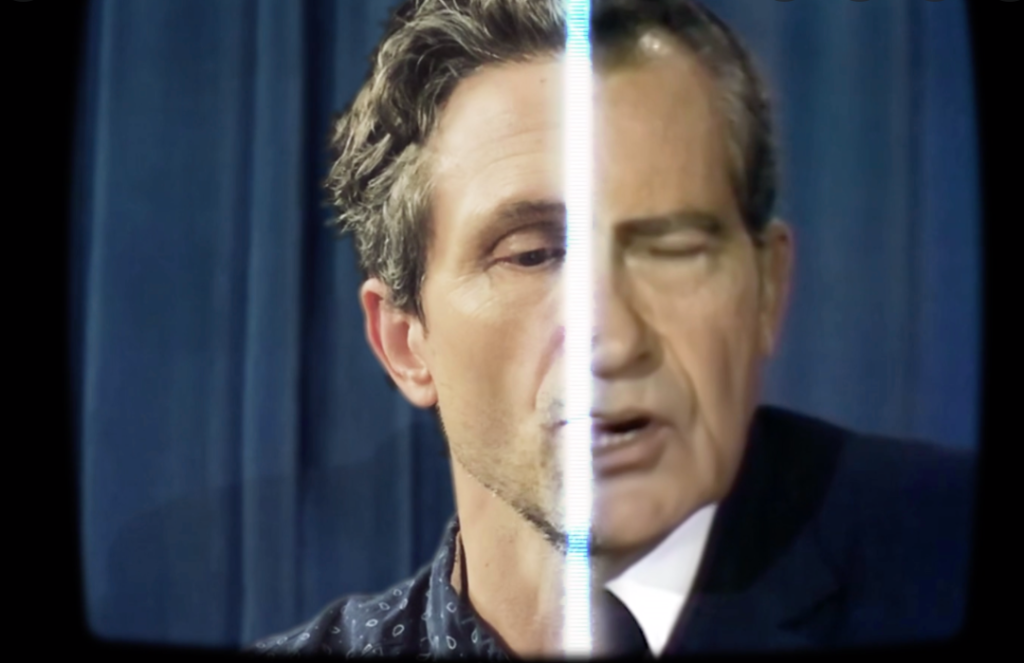

Facebook首席执行官马克·扎克伯格原创视频与深度伪造视频的对比。© The Washington Post via Getty Images

如何进行深度伪造?

高校研究人员和特效工作室一直以来都在在推动视频和图像处理突破可能性边界。深度伪造最初源于一个名为“deepfakes”的Reddit社交网站用户, 该用户于2017年在 Reddit上发布了经伪造过的色情视频片段。这些视频将色情演员换脸成盖尔·加朵(Gal Gadot)、泰勒·斯威夫特(Taylor Swift)、斯嘉丽·约翰逊(Scarlett Johansson)等名人。

众多女星成为深度伪造的受害者。© Guardian

制作一段换脸视频需要以下几个步骤。首先,你要运行一种叫做编码器的AI算法,对比数千张名人与小片片演员的面部照片,编码器会找出并学习两张脸之间的相似之处,并将其化为两人共有特征,在这个过程中,算法对图像进行压缩。然后,用另一称作解码器的AI算法来解压图像,恢复人脸。

人脸之间不尽相同,你需要训练一个解码器来恢复第一个人的脸,训练另一个解码器来恢复第二个人的脸。想要进行换脸,你只需将编码后的图像输入“错误”的解码器。例如,将A脸部的压缩图像输入B的解码器,然后,解码器用A的面部表情重建B的脸,要想制作出以假乱真的视频,就必须逐帧绘制,循环往复。

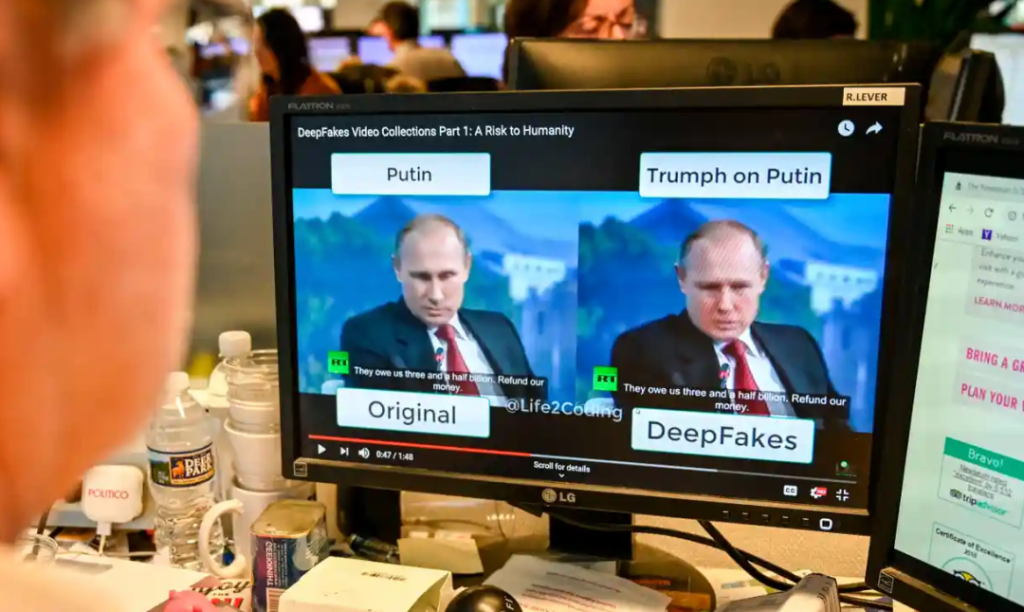

对比俄罗斯总统普京的原创和深度伪造视频。© Alexandra Robinson/法新社via Getty Images

另一种深度伪造的方法是使用生成对抗网络(generative adversarial network ),简称Gan。Gan让两种人工智能算法相互对抗,第一种算法称为生成器(generator),对其输入随机噪声,并将其转化为图像。然后,合成图像就被添加到如名人画像等真实图像中,再将这些真实图像输入到第二个算法——鉴别器(discriminator)之中。起初,这些合成图像和人脸相去甚远,但不断重复这一过程,加之性能反馈,鉴别器和生成器能力都会得到提高。只要有足够的循环和反馈,生成器就会开始生成极近逼真的名人脸,但这些名人却并不存在。

(research.nvidia.com/publication/2018-04_progressive-growing-gans-improved-quality-stability-and-variation)

深度伪造背后的践行者是哪些人?

从学术和工业研究人员到业余爱好者,从视觉效果工作室和色情作品制作者,每个领域几乎都有人涉猎。政府很有可能也会涉足这项技术,将其作为一大在线战略,用其给极端组织冠以臭名,并扰乱其运作,或者与目标人物取得联系。

深度伪造需要什么样的技术?

要是在普通电脑上进行深度伪造,想要做出以假乱真的效果简直是天方夜谭。

大多数深度伪造都是在高端台式机上创建的,其显卡算力极强,质量更高的深度伪造则是在云计算设备上制作生成,这将处理时间从数天或数周缩减至数小时,但同时制作者也需要掌握相关专业知识,尤其是优化、补全视频,减少闪烁和其他视觉缺陷,也就是说,现在有很多工具可以帮助人们进行深度伪造。

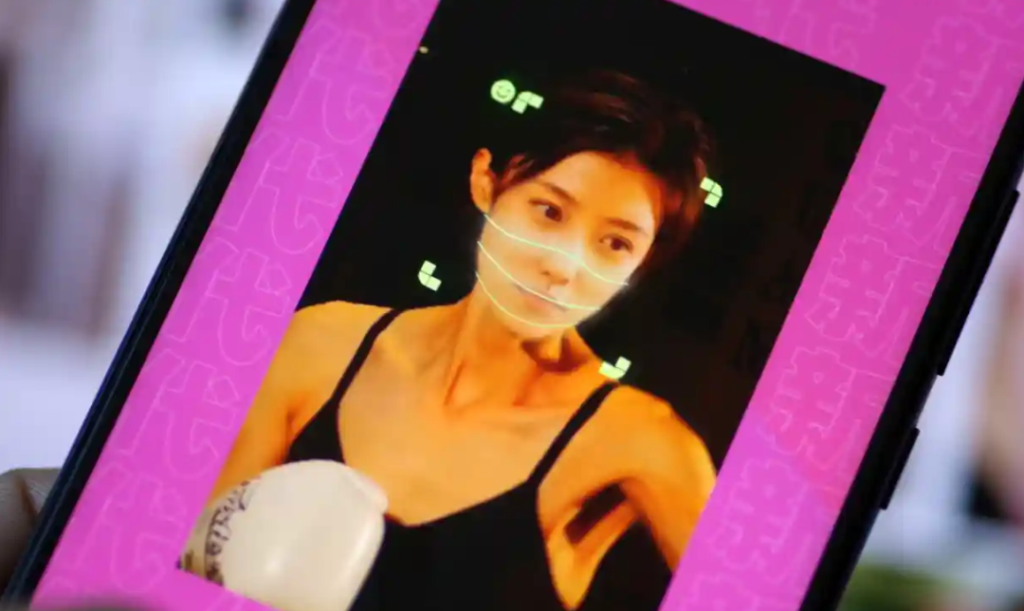

换脸应用程序Zao引发了隐私安全问题。© SIPA USA/PA Images

有几家公司会为人们制作这些工具,并在云端完成所有处理,甚至还有一款名为“Zao”的手机应用,算法在系统内对一系列电视和电影角色进行学习训练,用户可以自其中自行加入自己的脸部照片。

如何辨别深度伪造?

随着技术进步,辨别难度越来越大。2018年,美国研究人员发现深度伪造视频中的角色不会正常眨眼,这不足为奇:大多数图像中,人眼都是睁着的,所以算法从未真正学习过眨眼。起初,这似乎是辨别深度伪造灵丹妙药。但这项研究一经发表,深度伪造角色就学会了眨眼。这便是游戏本质:弱点一旦暴露,就会被修复。(arxiv.org/abs/1806.02877)

© The Official Microsoft Blog

劣质的深度造假更加容易被发现。角色口型可能对不上,肤色可能不协调,或者换脸后面部边缘可能会有闪烁,而像头发这类细节更是让深度伪造者头疼,难以将其渲染得当。渲染不好的珠宝和牙齿也可能暴露本质,奇怪的灯效也是祸源,比如照明情况不相一致、虹膜上的反射格格不入等。

TikTok上“深伪”的汤姆·克鲁斯。© TikTok

政府、高校和科技公司都在资助检测深度伪造的研究。2019年12月,由微软、Facebook和亚马逊赞助第一届深度伪造检测挑战赛拉开帷幕。届时全球各地的研究团队都会参与大赛,争霸深度伪造检测游戏。

(ai.facebook.com/datasets/dfdc/)

在2020年美国大选的准备阶段,Facebook禁止了深度伪造视频,这些视频可能会误导观众,让某些人遭受无妄之灾。然而,该政策只禁止人工智能生成的虚假信息发布,这就意味着,该平台上仍存在“浅层伪造(shallowfake)”(见下文)。

一名女子观看唐纳德·川普和巴拉克·奥巴马的深度伪造视频。© Rob Lever/AFP via Getty Images

深度伪造会造成严重破坏吗?

我们可以预见,此后深度伪造作品更是会雨后春笋般涌现,造成骚扰、恐吓、歧视、破坏,影响社会稳定,但深度伪造会引发重大国际事件吗?我们不得而知。

世界领导人按下大红色按钮(发射核弹)的深度伪造并不会引发世界末日,深度伪造的军队在边境集结的卫星图像也不会造成多大麻烦:大多数国家都有自己靠得住的安全成像系统。

马斯克直播抽大麻,导致特斯拉股价暴跌。© MIT Technology Review

尽管如此,深度伪造视频在制造麻烦这方面仍可以大施拳脚。2019年,埃隆·马斯克(Elon Musk)直播抽大麻,导致特斯拉股价暴跌。同年12月,唐纳德·川普在参加北约会议后提前飞回家,当时网上便流传出了其他世界领导人刻意嘲笑他的画面,以假乱真。

鱼目混珠的深度伪造会影响股价、影响选民投票,并引发宗教紧张局势吗?这似乎是必然。

深度会破坏信任吗?

实际上,深度伪造、其他合成媒体以及假新闻的影响远不止于此,更令人生厌的是,这些因素会创造出一个零信任社会,人们无法或者不愿再费心去分辨真假,明察是非。当信任的根基动摇时,人们更容易对具体事件提出质疑。

2018年,喀麦隆通信部长将一段视频斥为假新闻,大赦国际(Amnesty International)却对该视频深信不疑,视频中喀麦隆士兵正处决平民。

(www.amnesty.org/en/latest/news/2018/09/digitally-dissecting-atrocities-amnesty-internationals-open-source-investigations/)

唐纳德·川普承认在一段录音对话中吹嘘自己抓过女性下体,后来他表示,这段视频是假的。安德鲁王子接受英国广播公司艾米丽·梅特利斯(Emily Maitlis)采访时表示,对自己与弗吉尼亚·吉弗尔(Virginia Giuffre)合影的真实性表示怀疑,而弗吉尼亚的律师却坚称这张照片是绝对真实、未经篡改的。

(www.theguardian.com/us-news/2017/nov/29/denying-accuracy-of-access-hollywood-tape-would-be-trumps-biggest-lie)

纽卡斯尔大学(Newcastle University)网络法律权威专家莉莲·爱德华兹(Lilian Edwards)教授说:“问题可能不在于虚假的现实,而在于真实的现实似乎变得不置可否。”

2020年,韩国主播金珠河(Kim Joo-Ha)的新闻播报。实际上,这是深度伪造的金珠河,尽管播出前观众已被告知真相,但还是引起了公众的不同反应。© youtube

随着技术不断深入,人们获取技术更加方便 ,深度伪造可能会给法庭事务带来麻烦,尤其是处理在儿童抚养权之争和雇佣关系等问题上,伪造事件可能会因此成为证据。但深度伪造也会带来个人安全风险:深度伪造可以模拟生物识别数据,并有可能欺骗依赖面部、声音、静脉或步态识别的系统,借此蒙混过关。

显而易见的是,有人会利用这项技术进行诈骗。例如,某人突然接到电话要求他们打钱,他们不太可能会把钱转到一个未知的银行账户,但如果自己的“妈妈”或“姐姐”在WhatsApp上打了给你打了一通视频通话,并同样要求你转钱,你又会怎么做呢?

解决方案是什么?

讽刺的是,AI可能就是答案。

人工智能已经可以帮助人们识别假视频,但许多现有检测系统都存在一个致命缺陷:这些系统更适用于检测名人视频,因为名人视频在网上比比皆是,系统可以免费获得,并进行数小时的训练。科技公司现在正在研发检测系统,目的是在“假货”出现时便将其标记。

© Partnership on AI

另一种策略是关注媒体来源,数字水印并非万无一失,但区块链在线分类账系统可以保存视频、图片和音频的防篡改记录,因此这些多媒体的来源和任何篡改行为随时都处在监测之下。

深度伪造都是意图作恶吗?

非也。许多深度伪造是带有娱乐性质的,有些还尚有裨益。声音克隆深度伪造技术可以在人们因病失声时恢复其声音。深度伪造视频可以让画廊和博物馆充满活力。

深度伪造的达利。© youtube

在佛罗里达的达利博物馆中有一段深度伪造视频,视频中一位超现实主义画家介绍自己的艺术作品并与游客进行自拍。对于娱乐圈来说,科技可以用来改进外语影片的配音,更有争议的是,让过世演员死而复生。比如,已故的詹姆斯·迪恩(James Dean)将主演越南战争电影《寻找杰克》。

喜剧演员比尔·哈德尔(Bill Hader)模仿阿尔·帕西诺和施瓦辛格时候的深度伪造视频。© youtube

那浅层伪造呢?

萨姆·格雷戈里(Sam Gregory)在人权组织“证人”(Witness)工作,“浅层伪造”一词便是由他所创作,指的是视频内容断章取义或仅经简单的编辑工具修改。这些视频虽然质量低劣,但无疑具有影响力。一段浅层造假视频在社交媒体上流传,视频故意放慢了南希·佩洛西(Nancy Pelosi)的演讲速度,让人感觉其冗长啰嗦,虚化了美国众议院议长的声音,让其听起来含糊不清。

© ASSOCIATED PRESS

在另一起事件中,CNN记者吉姆·阿科斯塔(Jim Acosta)与总统发生激烈争执,被暂时禁止参加白宫新闻发布会。在随后发布的一段浅层伪造视频中,他与一名试图拿掉他麦克风的实习生发生了肢体接触。后来发现,该视频在关键时刻进行了加速处理,使得他的举动显得咄咄逼人。后来,阿科斯塔重新拿回了自己的媒体通行证。

(www.forbes.com/sites/laurenaratani/2018/11/08/altered-video-of-cnn-reporter-jim-acosta-heralds-a-future-filled-with-deep-fakes/?sh=621a6af23f6c)

英国保守党也使用了类似的浅层造假伎俩。在大选的准备阶段,保守党篡改了对工党议员基尔·斯塔默(Keir Starmer)的一次电视采访,让他看起来愚笨,无法回答有关保守党脱欧立场的问题。

深度伪造盛行的今天,这类恶作剧只会层出不穷。正如Deeptrace威胁情报(threat of intelligence)主管亨利·阿杰德(Henry Ajder)所言:“世界正愈发人工化,这项技术不会消失。”

文/Ian Sample

译/Zhao Hang

校对/兔子的凌波微步

原文/www.theguardian.com/technology/2020/jan/13/what-are-deepfakes-and-how-can-you-spot-them

本文基于创作共享协议(BY-NC),由Zhao Hang在利维坦发布

来源: 2022-08-04